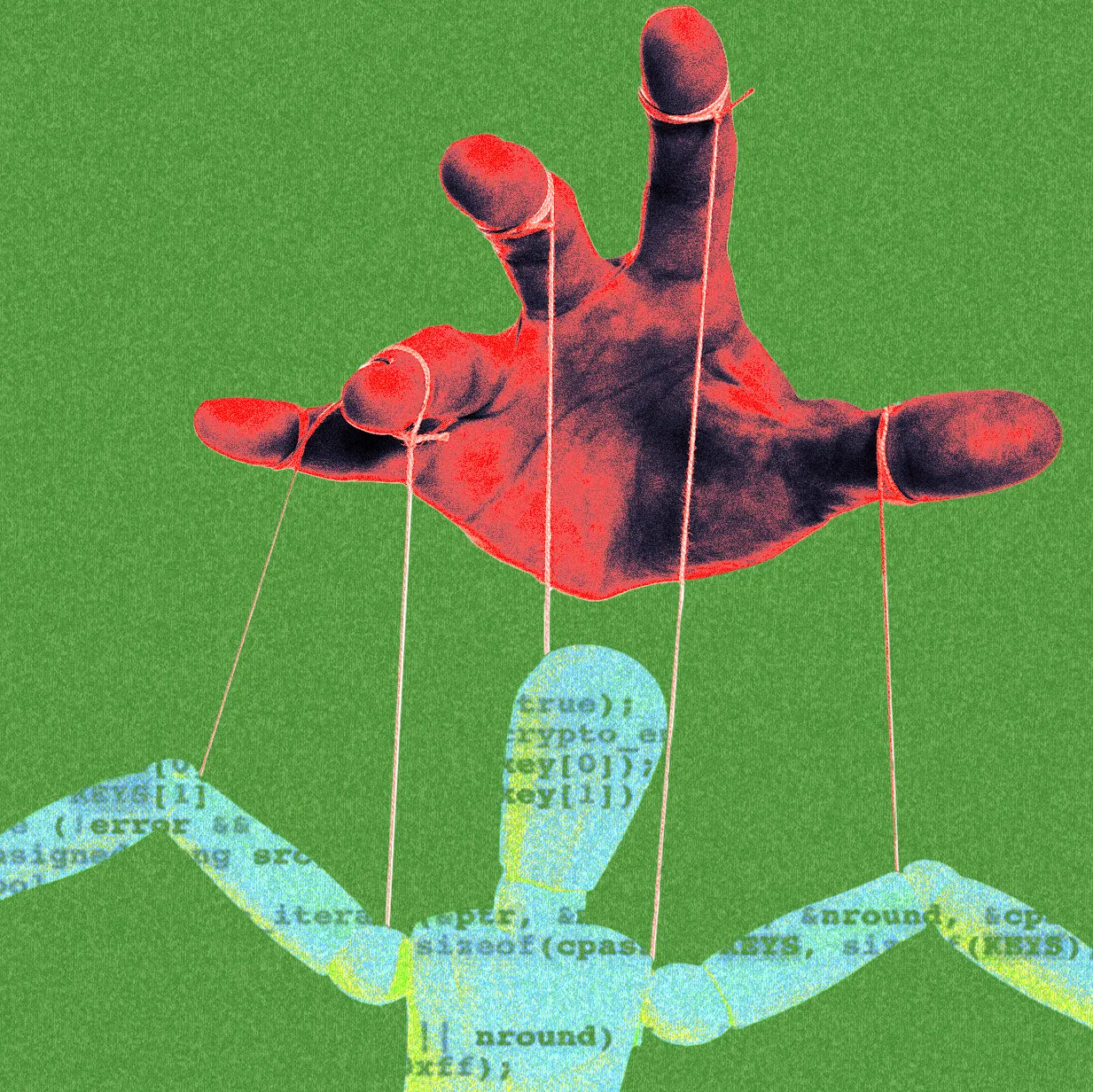

¿Las IA entienden o solo procesan?

Es tu asistente, oráculo, entrenador personal y hasta terapeuta, pero ¿realmente tu LLM de confianza puede razonar?

La industria de la inteligencia artificial vive de crear ilusiones. Ilusiones de inteligencia, de empatía, de creatividad. Pero ninguna es tan poderosa —o peligrosa— como la ilusión del pensamiento. Así lo sugiere un polémico estudio que desmonta con precisión quirúrgica una de las promesas más repetidas por las grandes tecnológicas: que sus modelos “razonan”. El documento, titulado The Illusion of Thinking, no proviene de una empresa cualquiera. Apple, que ha mantenido una postura relativamente cauta en la carrera por la IA generativa, irrumpe aquí no con un producto, sino con una crítica demoledora. Según sus hallazgos, incluso los modelos más avanzados —como GPT-4o de OpenAI, Claude de Anthropic o Gemini de Google— sufren colapsos masivos cuando se enfrentan a tareas que exigen razonamiento más complejo. No se equivocan un poco. Se equivocan de forma sistemática y radical. Más que un problema técnico, una crisis semántica El estudio no se limita a señalar errores de rendimiento. Va más allá, cuestionando directamente el lenguaje con el que las empresas presentan sus modelos al público. ¿De verdad están “razonando”? ¿O simplemente están completando texto con patrones estadísticos que suenan convincentes? El paper habla de una “ilusión de pensamiento” que es tanto técnica como comunicativa. Porque lo que hoy consideramos “razonamiento” en los modelos, no es más que una simulación de razonamiento: un conjunto de asociaciones probables, sin comprensión, sin intención, sin sentido del contexto. En otras palabras: no piensan. Solo parecen pensar. La narrativa de la inteligencia Durante el último año, los modelos de lenguaje han sido descritos como casi humanos. Capaces de planear, resolver problemas, debatir. Se les compara con asistentes expertos, copilotos de código, incluso oráculos. Pero lo que muestra el paper de Apple es que estas metáforas no solo son exageradas, son fundamentalmente engañosas. No es que los modelos fallen a veces. Es que, cuando el nivel de complejidad de una tarea supera cierto umbral —especialmente en contextos que requieren múltiples pasos de inferencia lógica— el rendimiento se derrumba. La ilusión desaparece, y nos encontramos con lo que siempre ha estado ahí: un sistema estadístico entrenado para predecir la siguiente palabra. ¿Importa que no razonen? Aquí está la verdadera pregunta. Si los modelos de lenguaje pueden generar código, escribir emails, resumir artículos o responder preguntas médicas, ¿importa que no “piensen”? Tal vez no, siempre y cuando no olvidemos ese límite. El problema es cuando confundimos desempeño con comprensión. Cuando atribuimos intención a un sistema que solo sabe correlacionar palabras. Y eso ya está ocurriendo. Hoy hay empresas que prometen “IA con criterio”. Gobiernos que consultan a estos sistemas para políticas públicas. Profesores que los usan como tutores automatizados. El riesgo no es que estos modelos fallen, sino que nadie note cuando lo hacen. La ilusión funciona, hasta que deja de hacerlo El artículo de Apple no resuelve todos los debates, pero lanza una advertencia clara. Si seguimos construyendo expectativas alrededor de la idea de que los modelos actuales piensan, nos preparamos para una serie de desilusiones que pueden tener consecuencias reales: diagnósticos errados, decisiones automatizadas injustas, sistemas autónomos fuera de un control humano. Más que máquinas que piensan, lo que tenemos hoy son espejos lingüísticos: reflejan lo que han visto, lo recombinan, lo embellecen. Pero no lo entienden, y no deberíamos esperar que lo hagan. Pensar no es solo predecir Pensar, en los humanos, implica incertidumbre, revisión, autoconciencia. Ninguna de estas cualidades está presente en los LLM actuales. Y sin embargo, la ilusión de pensamiento es tan seductora que imaginamos que todo eso está en la interacción, porque nosotros como seres comunicativos lo necesitamos. Quizás lo más valioso de este estudio no es lo que revela sobre los modelos, sino lo que dice de nosotros: cuánto deseamos creer que hemos creado una inteligencia artificial, cuando quizá apenas hemos logrado una poderosa maquinaria de palabras que hasta la fecha no deja de asombrarnos.

Etiquetas:

Sin Etiquetas

Mejores Noticias

Justo Ahora